Einleitung

Das Wort „Blockchain“ fiel erstmalig im Zusammenhang mit Bitcoin als dezentrales Netzwerk für Zahlungen in der gleichnamigen digitalen Währung. Hierbei beschreibt die Blockchain eine zugrundeliegende Technologie, in der alle Transaktionen öffentlich und unveränderbar verzeichnet sind. Dazu wird mittels kryptografischer Verfahren die Korrektheit aller Transaktionen sichergestellt – beispielsweise die richtige Transaktionsreihenfolge, Verhinderung der doppelten Ausgabe eines Bitcoins bei einer Zahlung oder Schutz vor Manipulation einer Transaktion. Der entscheidende Punkt ist die Tatsache dass keine zentrale Vertrauensinstanz notwendig ist, da die Teilnehmer dem Inhalt der Blockchain selbst vertrauen.

Aber die technische Entwicklung schreitet mit hoher Geschwindigkeit fort. Daher fällt der Begriff „Blockchain“ mittlerweile nicht nur im Zusammenhang mit digitalen Währungen. Vielmehr ist von einer Technologie die Rede, welche bestehende Produkte, Dienstleistungen und sogar Geschäftsmodelle disruptiv beeinflussen wird.

Um die Potentiale und Auswirkungen der Blockchain-Technologie besser beurteilen zu können, haben sich in den letzten Jahren verschiedene Firmen aus unterschiedlichen Technologien und vor allem Finanzbereichen in Konsortien zusammengeschlossen:

- Das R3 Konsortium, welches vornehmlich einen Zusammenschluss von rund 80 Firmen aus der Finanzwirtschaft (UBS, Credit Suisse, Deutsche Bank, Commerzbank, …) ist. (R3CEV LLC, 2017)

- Das IoT-Consortium, zu dem u.a. Bosch Ltd. Cisco Systems Inc. gehören, untersucht inwiefern Blockchain-Technologie zur Absicherung und Verbesserung von IoT-Netzwerken eingesetzt werden kann. (Faife, 2017)

- Im Hyperledger(Enterprise Ethereum Alliance) Konsortium haben sich mehr als 120 Firmen aus dem Bereich Finanzen, Banken, IoT und der Industrie organisiert. (Hyperledger)

- Enterprise Ethereum Allianz mit rund 500 Startups, Unternehmen, Akademische Einrichtungen aus den unterschiedlichsten Bereichen. (Förster, 2017)

Darüber hinaus wurden im Jahr 2016 rund 500 Mio. USD an Venture-Kapital für Blockchain-Technologien in Startups und Technologie-Firmen investiert. (Coindesk)

Auch wenn nach heutigem Stand noch nicht genau ersichtlich wird, für welche Bereiche und Anwendungsgebiete Blockchain-Technologien verwendet werden können, so wird daraus doch ersichtlich, dass dieser neuen Technologie ein großes Potential zugetraut wird.

Im nachfolgenden möchte dieser Beitrag eine kurze Einführung in die Blockchain-Technologie geben und aufzeigen in welchen Gebieten Potentiale und mögliche Anwendungsfelder liegen.

Was ist die Blockchain (Definition)?

Blockchain ist eine neue Technologie zur Verifizierung von Datentransaktionen in einem dezentral organisierten Netzwerk mittels kryptografischer Verfahren. Die Blockchain bietet Nachvollziehbarkeit sowie Fälschungssicherheit von Transaktionen, ohne dabei auf eine zentrale Instanz angewiesen zu sein. (Voshmgir, 2017)

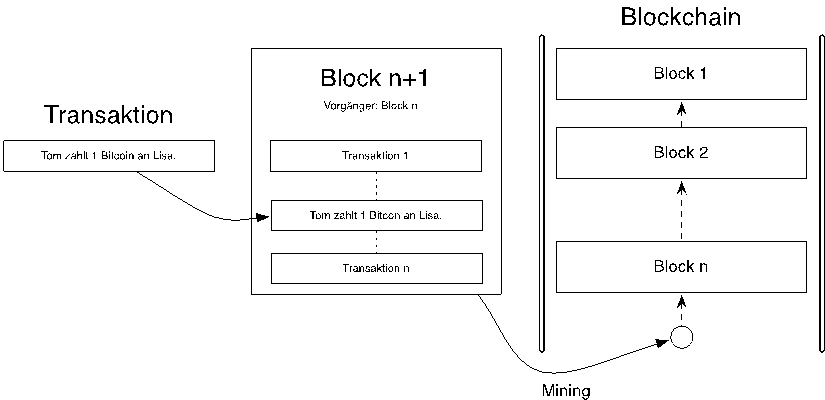

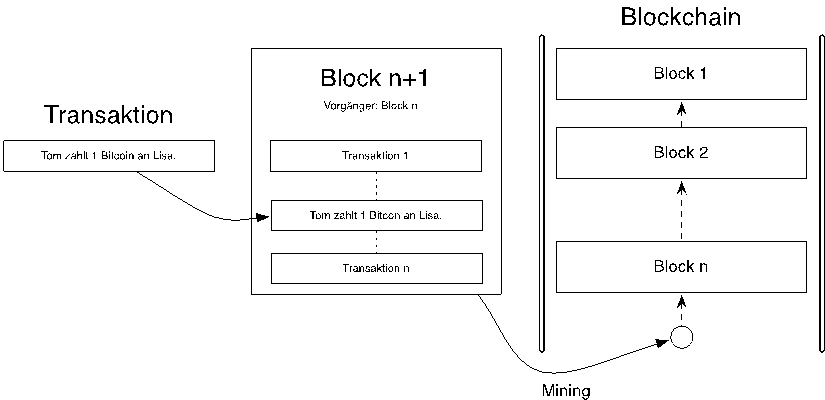

Die nachfolgende Abbildung zeigt vereinfacht den prinzipiellen Aufbau einer Blockchain. Wie der Name suggeriert, werden in einer Blockchain einzelne Blöcke aneinander „gekettet“. Dabei zeigt ein Block immer auf seinen Vorgänger, wodurch in der Blockchain eine verifizierbare Kette von Blöcken entsteht, welche vom aktuell letzten Block bis zum ersten Block reicht. Der erste Block wird im Allgemeinen auch als Genesis-Block bezeichnet, da dieser keinen Vorgänger besitzt.

Innerhalb eines Blocks werden dann die einzelnen Transaktionen verzeichnet. Eine Transaktion kann wie im Beispiel ein Zahlungsvorgang sein. Aber es kann auch etwas ganz anderes sein wie z.B. ein Lieferschein oder eine Garantieurkunde. Vom Prinzip her können Blockchains alle möglichen Daten wie Texte, Bilder oder gar Programmcode speichern.

Abbildung 1 Blockchain; eigene Darstellung

Damit eine neue Transaktion in der Blockchain gespeichert werden kann, muss ein neuer Block generiert, die Transaktion darin verzeichnet und der Block an die bestehende Blockchain angehängt werden. Dieser Prozess wird als „Mining“ bezeichnet und unterliegt bestimmten Regeln. Die Regeln werden vom Protokoll der Blockchain vorgegeben und dienen dazu, den Konsens zwischen allen Teilnehmern zu ermöglichen.

Denn sobald ein Block erfolgreich an die Blockchain „angekettet“ wurde, werden alle Transaktionen innerhalb des Blocks von den Teilnehmern als valide angesehen.

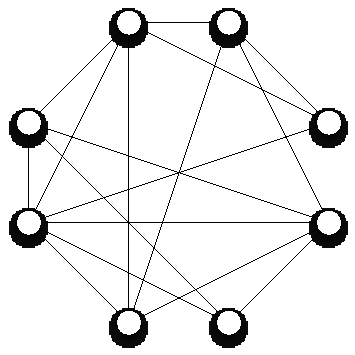

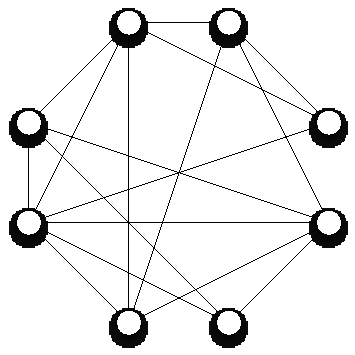

Abbildung 2 Peer-to-Peer Netzwerk, eigene Darstellung

Die Verteilung der Blockchain erfolgt dezentral über ein Peer-to-Peer Netzwerk in welchem alle Knoten untereinander gleichberechtigt sind. Weiterhin ist jeder Knoten mit mehreren anderen Knoten des Netzwerks verbunden, um untereinander den aktuellen Stand der Blockchain auszutauschen sowie neue Transaktionen im Netzwerk zu verbreiten. So können diese dann in einem späteren Block aufgenommen werden. Als weitere Aufgabe überprüft jeder Knoten den aktuellen Stand der Blockchain auf Einhaltung der Regeln.

Vergleicht man dies nun mit aktuellen verteilten Datenbanksystemen, sind diese überwiegend zentral organisiert. So gibt es einen Masterknoten, welcher die Datenhoheit über getätigte Transaktionen besitzt und dem alle anderen Knoten (Slaves) vertrauen. Eine Validierung findet hier bei den angeschlossenen Slaves nicht statt. Dadurch sind diese Systeme anfällig für Manipulationen, wenn beispielsweise der Masterknoten durch einen Akteur infiltriert wird und über diesen dann manipulierte oder falsche Informationen verteilt werden.

Im Gegensatz dazu sind im Blockchain-Netzwerk alle Knoten gleichberechtigt und jeder Knoten überprüft die Blockchain auf Einhaltung der Regeln. Sollte somit ein Knoten manipulierte oder fehlerhafte Informationen verteilen, so würde dass von den anderen Knoten unmittelbar erkannt werden.

Weiterhin hat das Netzwerk auf Grund der hohen Redundanz eine sehr hohe Ausfallsicherheit, da jeder Knoten eine Kopie der Blockchain besitzt. Somit ist es unempfindlich gegen Ausfälle falls einzelne Konten nicht mehr erreichbar sind, sei es aus technischen oder politischen (Zensur) Gründen.

Blockchain-Plattformen

.

Public Blockchain-Plattform

Bei der bis jetzt beschriebenen Architektur für eine Blockchain handelt es sich um eine „Public Blockchain-Plattform“. Das heißt, jeder kann die Blockchain verwenden, indem er beispielsweise selbst einen Knoten betreibt, der sich dann mit dem Netzwerk verbindet. Eine Limitierung des Zugangs zum Netzwerk existiert nicht.

Somit sind die Daten innerhalb der Blockchain transparent, da alle Teilnehmer alle Transaktionen einsehen können. Gleichzeitig bleibt durch Kryptografie die Privatsphäre gewahrt, da eine Zuordnung einer Transaktion zu einer Organisation, Firma oder Person nicht ohne weitere Informationen möglich ist. Allerdings ist die Performance eines solchen Netzwerks verglichen mit einem verteilten Datenbanksystem gering. So sind im Bitcoin Netzwerk aktuell (Stand April 2017) maximal 7 Transaktion/Sekunde möglich von denen derzeit rund 4 Transaktionen/Sekunde erreicht werden.

Weiterhin ist die Blockgröße auf 1 Mbyte limitiert wobei ungefähr alle 10 Minuten ein neuer Block hinzukommt. Dies spiegelt sich auch in den Gebühren für eine Transaktion wieder.

Um die Grenzen der oben genannten Limitierung weiter hinauszuzögern haben sich neben der Public Blockchain mit der Private Blockchain und der Consortium Blockchain zwei weitere Ansätze herausgebildet. Hierbei wird der Anspruch an ein vollkommen dezentrales Netzwerk, in dem alle Knoten gleichberechtigt sind, herabgesetzt. Dadurch wird vor allem eine signifikante Erhöhung der Transaktionsrate pro Sekunde mit gleichzeitiger Absenkung der Transaktionskosten erreicht. (Thompson, 2016)

Beispiele für Public Blockchain-Plattformen:

- Bitcoin (Netzwerk für Zahlungen)

- Ethereum (Smart Contract Plattform)

Private Blockchain-Plattformen

Private Blockchain-Plattformen werden von einem einzelnen Anbieter (bspw. einer Firma oder Organisation) entwickelt und betrieben. Dieser hat somit die Hoheit über die Regeln zum Erreichen des Konsens innerhalb der Blockchain sowie welche Transaktionen in die Blöcke aufgenommen werden. Dies setzt einen hohen Grad an Vertrauen in den Betreiber voraus. Der Vorteil ist aber, dass es möglich ist den Teilnehmerkreis stark einzuschränken, welcher lesenden Zugriff auf die Informationen innerhalb der Blockchain erhält. Dies kann je nach Anwendungsfall wünschenswert sein.

Beispiele für Private Blockchain-Plattformen

- – IBM Hyperledger, Blockchain-as-a-Service (BaaS)

Consortium Blockchain-Plattformen

Consortium Blockchain-Plattformen sind private Blockchains mit dem Unterschied, dass diese von mehreren Anbietern, welche sich zusammengeschlossen haben, entwickelt und betrieben werden. Dadurch wird die „Macht“ über das Netzwerk auf mehrere vorausgewählte Teilnehmer verteilt.

Beispiele für Consortium Blockchain-Plattformen

- Hyperledger

- Ethereum Enterprise

- Ripple

Diese Art von Blockchains hat das derzeit größte Potential, die Bedürfnisse spezifischer Märkte nach automatisierten, hoch sicheren Transaktionen abzubilden.

Die folgenden Artikel dieser Beitragsreihe „Blockchain – Verbesserung der Transaktionssicherheit durch Kryptografische Verkettung“ werden sich mit den fünf ausgewählten Merkmalen beschäftigen, die beim Einsatz von Blockchain Technologie relevant sind sowie Anwendungsfälle und Einsatzszenarien vorstellen.

Weitere interessante Artikel finden Sie in unserem Blog

Literaturverzeichnis

Coindesk. (kein Datum). Blockchain Venture Capital. Abgerufen am 10. April 2017 von

Enterprise Ethereum Alliance. (kein Datum). Enterprise Ethereum Alliance. Abgerufen am 10. April 2017 von http://entethalliance.org

Förster, M. (1. März 2017). Heise.de. Abgerufen am 10. April 2017 von Blockchain: Enterprise Ethereum Alliance ins Leben gerufen: Blockchain: Enterprise Ethereum Alliance ins Leben gerufen

Faife, C. (27. Januar 2017). CoinDesk. Abgerufen am 10. April 2017 von Bosch, Cisco, Gemalto and More: Tech Giants Team Up For Blockchain-IoT:

Hyperledger. (kein Datum). Blockchain Technologies for Business. Abgerufen am 10. Aprli 2017 von https://www.hyperledger.org

MAL, S. N. (7. Februar 2017). NEUN MAL SECHS. Abgerufen am 10. April 2017 von

R3CEV LLC. (2017). R3. Abgerufen am 10. 4 2017 von

Thompson, C. (2016. Oktober 2016). Blockchain Daily News. Abgerufen am 20. April 2017 von The difference between a Private, Public & Consortium Blockchain.:

Voshmgir, S. (30. Januar 2017). Blockchains, Smart Contracts und das Dezentrale Web. 36. (T. S. Berlin, Hrsg.) Berlin, Berlin, Deutschland.

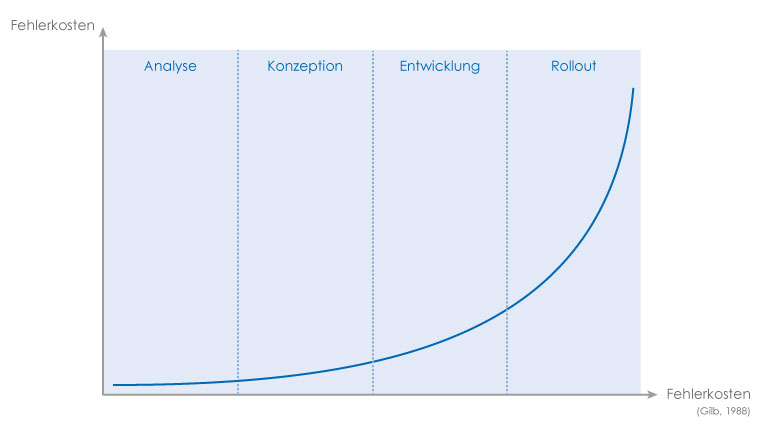

Hier stellen Prototypen ein besseres Medium dar, um eine Produktidee oder ein Konzept zu kommunizieren. Prototypen helfen, die Software schon erfahrbar machen, bevor die erste Zeile Code geschrieben wurde. Dabei muss es sich weder um programmierte Prototypen handeln, noch müssen die entstandenen Entwürfe pixelgenau ausgestaltet sein. Entscheidend ist, dass der Prototyp das kommuniziert und erlebbar macht, was gerade im Projektteam oder mit den Endnutzern besprochen wird.

Hier stellen Prototypen ein besseres Medium dar, um eine Produktidee oder ein Konzept zu kommunizieren. Prototypen helfen, die Software schon erfahrbar machen, bevor die erste Zeile Code geschrieben wurde. Dabei muss es sich weder um programmierte Prototypen handeln, noch müssen die entstandenen Entwürfe pixelgenau ausgestaltet sein. Entscheidend ist, dass der Prototyp das kommuniziert und erlebbar macht, was gerade im Projektteam oder mit den Endnutzern besprochen wird.